近年、機械学習やディープラーニングの一般化に伴い、多種多様なGPUが提供されています。「必要なスペックや種類を具体的に知りたい」と、興味がある方も多いのではないでしょうか?

今回は、機械学習・ディープラーニングにおすすめのGPUをパフォーマンス別に紹介します。また、選び方のポイントの解説を通じて、GPUの導入で失敗しないコツを理解できます。PC選びで後悔しないためにも、ぜひ最後までご覧ください。

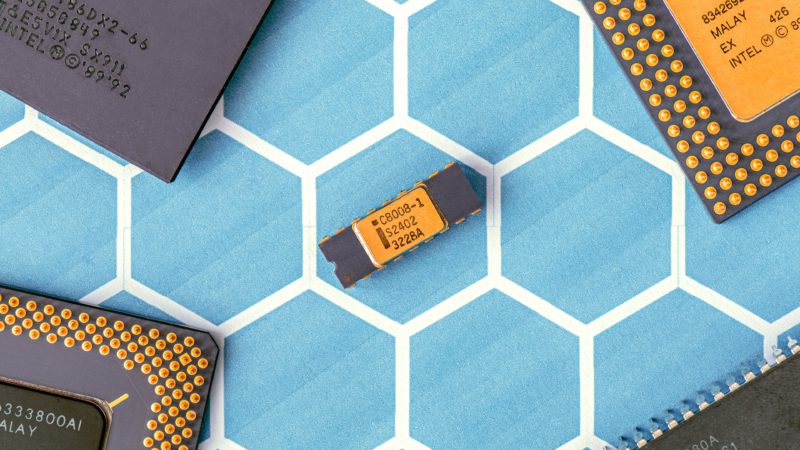

GPU本来の役割

GPUはGraphics Processing Unitの略称で、その名の通りグラフィックの計算処理を司るプロセッサです。

コンピュータは基本的にすべての計算処理をCPU(Central Processing Unit)で実行しますが、グラフィック技術の進化に伴い、その処理に膨大なリソースが必要になり始めました。そのため、CPUだけでグラフィックの処理も賄うことは難しくなり、グラフィック専門のプロセッサとしてGPUが搭載されたという背景があります。

1990年代以降から本格的な活用が始まったGPUですが、現在においても主な役割は基本的に同様です。4K画質での映像編集や、ビデオゲームのプレイングなど、映像負荷の大きなタスクを実行するためには高性能なGPUが欠かせません。

そして、もう一つGPUに注目が集まっている分野として、人工知能や機械学習での活躍が挙げられます。近年のAI開発において、GPUは欠かせない存在となり、多くの企業や研究機関で膨大なGPUリソースの確保が進んでいます。

そもそも機械学習・ディープラーニングとは

そもそも機械学習・ディープラーニングとは、それぞれAI技術に含まれるモデルの総称です。ディープラーニングは機械学習モデルの一つでもありますが、独自に研究が進められ多数のモデルが存在するため、機械学習とは分けて使われることが一般的です。

ここでは、具体的なモデルを紹介しながらそれぞれの違いを詳しく解説します。

機械学習とは

機械学習とは、コンピュータが数式やアルゴリズムに基づいてデータのパターンを学習し、未知のデータを予測するAI技術です。機械学習は学習方法の違いから、次の3つに分類できます。

- 教師あり学習:入力・出力データの関係性を学習する

- 教師なし学習:入力データの特徴やパターンを学習する

- 強化学習:推測結果の価値が最大となるパターンを学習する

たとえば、教師あり学習には、線形・非線形変換を利用した「ニューラルネットワーク」や、あり・なしの分岐で分類する「決定木」などが含まれます。また、教師なし学習には「クラスタリング」、強化学習には「モンテカルロ法」などがあります。

機械学習は、人間では識別できない新たなパターンを見出せる技術として、近年特に研究が進められている分野です。

ディープラーニングとは

ディープラーニングとは、ニューラルネットワークの上位モデルで、データのパターンを抽出する「中間層」と呼ばれる層が3層以上あるモデルのことを指します。

たとえば、時系列要素を抽出できる「LSTM」や、畳み込み演算で画像の特徴を抽出する「CNN」など、さまざまな特徴を持つディープラーニングモデルがあります。また、近年では「GAN」や「DQN」のように、教師なし学習・強化学習とディープラーニングを組み合わせたモデルも多く研究されています。

機械学習やディープラーニングにGPUが選ばれる理由

元々はグラフィック特化のプロセッサだったGPUが、いつの間にか機械学習分野で活躍するようになったのにはどのような理由があるのでしょうか?

豊富な運用実績

一つは、GPUが機械学習の分野で既にインパクトのある実績を打ち立てているためです。さまざまな功績がある中で、人工知能分野におけるGPUの有用性を証明するきっかけとなったのが、ディープラーニング研究です。

毎年開催されている画像認識の世界大会、 ImageNet Large Scale Visual Recognition Challenge(ILSVRC)の2012年大会では、トロント大学の研究チームが当時としては驚異的な認識率の高さを発揮して優勝しました。ここで用いられていたのが機械学習の一種であるディープラーニングの技術で、GPUを使って計算処理の高速化を実現し、短期間で認識精度を高めることに成功したことが話題となったのです。

この結果、2013年度以降はほぼすべての研究チームが2012年のトロント大学の方式を採用し、ディープラーニングとGPUの併用が現在のAI研究の主流となりました。

並列処理能力の高さ

GPUが人工知能分野においてこれまで高い成果を残せたのは、そもそもGPUというプロセッサの仕組みが機械学習に最適である点も大きいでしょう。GPUはグラフィックを専門としたプロセッサですが、グラフィック処理は単調な計算処理が数多く発生するため、並列処理能力に長けています。

通常のCPUの場合、計算処理は直列で一つずつ計算を解いていく仕組みです。一方、GPUは同じ計算を一度に複数対応できる仕組みとなっているため、大量の計算をこなせるよう設計されています。

機械学習においても、グラフィック処理同様大量の単純計算をこなさなければなりません。そのため、GPUは機械学習においてもパワフルなパフォーマンスを発揮するのです。

計算内容の複雑化

パワフルなGPUが求められるのは、単純にAI研究がどんどん複雑になっていることも理由に挙げられます。

ディープラーニングは機械学習の仕組みを発展させた高度な学習方法ですが、実施のためには大量のリソースが必要です。高性能なGPUを用意しなければまともな計算処理を行えず、他の企業や研究機関に遅れをとることとなります。

自動運転の実現や医療向けAIの開発など、繊細で正確な認識が求められるAIには、GPUやディープラーニングの技術が欠かせません。

GPUなしで機械学習・ディープラーニングは可能?

結論からお伝えすると、機械学習もディープラーニングもGPUなしでは十分に学習できません。データサイズを小さくしたり転移学習を利用したりと工夫すれば、動かせるモデルもありますが、一般的にはCPUだけではメモリなどのスペック不足で、学習が止まってしまいます。

特に、ディープラーニングでは大量のデータを使い、大規模な演算を繰り返し行うため、高性能なGPUが必要になります。そのため、機械学習・ディープラーニングの研究・開発をスムーズに進めるためには、高性能なGPUを用意するようにしましょう。

機械学習やディープラーニングに必要なPCのスペック

ここで、機械学習をPCで実行する場合、どのようなスペックが求められるかを確認しておきましょう。

GPU

機械学習をどのレベルで実施するかによって、必要なスペックは変わります。個人的にAIの仕組みを学ぶ程度であれば一般的なPCでも十分に対応できますが、可能であればGPUのスペックにこだわると良いでしょう。

ビデオメモリ容量の多いグラフィックボードを導入できれば一度に計算できる量が増え、効率的な学習を進められます。複数枚のGPUを導入できる拡張性を備えているハードもあり、今後ハイスペック環境を求めている場合にはこういったモデルを購入するのも良いでしょう。

また、ディープラーニングに特化したコアを備えるGPUも登場しているため、本格的なAI開発を始めたい場合には参考にしてください。

CPU

CPUはコンピュータ全体の処理を司るため、高性能であればあるほど良いですが、余裕があれば問題ない程度です。GPUより優先してグレードを引き上げる必要はないので、現世代機に標準装備されているモデルを使えば大丈夫です。

メモリ

メモリ容量については、グラフィックボードに搭載のビデオメモリの容量の方が重要になるので、メインメモリもCPU同様、標準的な能力があれば問題ありません。

ただ、メモリは処理すべきタスクを一時的に保管する役割を有しているので、たとえメインメモリでも容量に余裕を持った方がサクサクとソフトを動かすことができます。あえてアップグレードする必要はありませんが、PCの操作に使用をきたすようなダウングレードは控えましょう。

ストレージ

ストレージは、PCにデータを保存しておくために必要です。HDDモデルとSSDモデルがありますが、できればSSDモデルがおすすめです。

SSDの方が大容量データを扱いやすく故障率も低いため、ハードな計算処理が発生する場合に頼りになるからです。動作音も静かなので、ストレスフリーの運用を実現します。

OS

OSを選ぶ際にはWindowsとMac OSのどちらかを選択することとなりますが、どちらでも構いません。「Windows専用「Mac専用」といったソフトもありますが、どちらの環境でも十分に学習は進められるため、使い慣れているものを使用すると良いでしょう。

GPUの種類

GPUにはいくつかの種類がありますが、大きく次のような分類をすることができます。

映像表現に特化したタイプ

最もポピュラーなGPU製品として、映像表現に特化したモデルが挙げられます。

GPUは元々グラフィック処理に特化したユニットなので、必然的に映像表現技術が多く搭載された製品が揃っているのが特徴です。AI技術を使って滑らかな描写を実現したり、4Kや8K出力に対応したモデルだったりと、高度な映像表現を実現したい方におすすめの製品です。

映像表現に強いGPUを選ぶべき人としては、ゲーミングPCを組み上げたい方や、映像編集などに携わる方など、プロ・アマを問わず広く挙げられます。

AI開発に強いタイプ

近年増加傾向にあるのが、AI開発に強みを発揮する機能を備えたGPUです。たとえば、大手GPUメーカーのNVIDIAは、人工知能の学習効率化を実現する「Tensor コア」を備えたGPU製品を、盛んに開発しています。

GPUがディープラーニングなどのAI開発において有効であることが証明されたのは10年以上も前のことですが、近年はAI領域における強力なニーズを解消すべく、こういった製品の注目度も高まっています。

もちろん、AI開発に特化したGPUでなくとも機械学習やディープラーニングは実行可能ですが、余裕があれば上記のようなAI特化の製品も検討すると良いでしょう。

その他デュアルGPU対応モデルなど

GPUには、他にもさまざまなバリエーションがあります。

やや趣向は変わりますが、たとえば複数のGPUを同時に運用するのに適した製品などが挙げられます。GPUを2枚同時に使用する活用方法は「デュアルGPU」と呼ばれ、GPUを同時運用する際の効率を、通常のGPUよりも高められる設計が採用されています。

本格的なビジネス目的でディープラーニングを実践したい場合、一般的なGPUとは一線を画す、ハイエンドGPUなども選択肢に挙がるでしょう。

通常、GPUの価格は数万円から数十万円程度ですが、最先端の研究機関などで採用されているGPUは、一基あたり100万円を超える製品も珍しくありません。このようなGPUを一度に何基も導入することで、高性能なAI開発を実現可能です。

GPUには多様な種類があるため、自社の導入目的や必要なスペックに合わせて製品選びを進めましょう。

GPUの2つの代表的なメーカー

先ほど少し触れましたが、ここでGPUの代表的なメーカーについても確認しておきましょう。基本的に、GPUは次の2社から提供しているものしか世界には普及していません。

NVIDIA

NVIDIAは、GPUメーカーとして最も知名度の高い会社といえます。ゲーミングGPUからAI開発GPUまで、あらゆる目的に応じたGPUを世界中で提供しており、GPU搭載のPCの多くは同社のGPUを採用しています。

代表的なGPUラインとしては一般向けの「RTX・GTX」シリーズや、ハイエンドGPUの「Tesla」シリーズなどが挙げられます。

AMD

NVIDIAほどではないものの、AMDはNVIDIA同様に高いシェアを誇るメーカーです。

NVIDIAと異なるのは、AMDはGPUの開発はもちろん、CPUの開発も行っている点です。GPUはNVIDIAでも、CPUはAMDというPCも多く、AMD製CPUとの相性を考え、GPUもAMD製品にするというケースも珍しくありません。

代表的なGPUラインは「Radeon」シリーズですが、近年はAI向けの「Instinct」シリーズなども注目を集めています。

機械学習やディープラーニングに最適なGPUを選ぶポイント

GPUにもさまざまなラインナップが存在するため、機械学習に最適のモデルを見つける上では理解しておくべきポイントがあります。

チップメーカーに注目する

一つ目は、チップメーカーです。ディープラーニングや機械学習に活躍するGPUは、チップメーカーによっても差があります。

機械学習の際に採用されることが多いチップメーカーがNVIDIAです。NVIDIA製品を用いたAI開発事例は豊富で、多くの実績を残していることから、選ばれる傾向にあるメーカーです。

NVIDIAは機械学習を抜きにしてもGPU業界では知名度が高く、豊富なラインナップを備えているため、ノウハウもネットで検索すればすぐに調べられる強みもあります。機械学習に使えるツールや機能も豊富で、市販のPCもNVDIA製を好んで採用しているので、NVIDIAを選んでおけば間違いはありません。

想定している使用シーンを確認する

GPU選びにおいては、どんな目的で機械学習を実施したいのか確認しておくことも大切です。

後述しますが、 GPUは目的に合わせた複数のラインナップが存在します。個人用PCで趣味としてAIを開発するのか、ビジネスや研究のためにパワフルのAIを開発したいのかによって、必要なスペックや機能要件は異なります。

目的をスムーズに達成するためにも、使い道をはっきりとさせてからGPUを選ぶことが賢明です。

Tensorコアの有無を確認する

Tensorコアは、NVIDIA製のGPUに搭載されているユニットの一種です。NVIDIAが独自に開発した技術で、ニューラルネットワークの構築を高速化したり、ディープラーニングの学習効率を高めたりといったパフォーマンスを実現します。

Tensorコアが導入されているGPUは新しいモデルに限定されているため、古いGPUや安価なモデルには搭載されていない可能性があります。NVIDIA製品のGPUを購入する場合、Tensorコアの有無をスペック見ながら確認することをおすすめします。

機械学習やディープラーニングにおすすめのGPU:ハイパフォーマンス

まずは、機械学習において高速で計算処理を行い、迅速に学習モデルを構築できるハイパフォーマンスなGPUをご紹介します。

NVIDIA® RTX™ A6000

GPUメーカーとして最もポピュラーなNVIDIAは、人工知能開発をはじめとする高度な業務の遂行に向けたハイエンドGPUを販売しています。RTX A6000はそんなNVIDIAが誇るハイパフォーマンスなGPUの一つで、デスクトップで駆動するGPUとしては最高レベルの演算処理能力をユーザーに届けます。

高度な演算処理が必要な3D CADやコンピュータ支援エンジニアリング(CAE)といった業務を想定して開発されたモデルで、複雑なシミュレーションでも滑らかな挙動を実現できることが特徴です。

行列演算を処理するための最新モデルであるTensor Float 32(TF32)演算の採用により、従来製品よりもはるかに高速でのAIモデルの学習を可能にしている点も強みです。

AMD Instinct™ MI100

NVIDIAと対をなすGPUメーカーとして広く知られているのが、AMD社です。同社が提供するInstinct MI100は、新時代のコンピューティングを支えるモデルとして開発された、世界最速を掲げるHPC GPUです。HPCはハイパフォーマンスコンピューティング(High Performance Computingの略称で、GPUの並列処理能力を前提とした計算ツールです。

従来のGPUコンピューティングよりも大規模かつ高度なタスクを実践できることから、最先端の研究を支える技術として注目されていますが、MI100はそんな最新のGPU活用に適したモデルとなっています。

特にAIや機械学習分野では優れた成果を残せるポテンシャルを秘めており、従来モデルよりも2倍近い高速処理も実現可能です。

NVIDIA® H100

NVIDIAのH100は、リアルタイムでのディープラーニング推論や大規模な言語AIモデルなど、高度なディープラーニングモデルの開発にも対応可能なハイスペックなGPUですGPUメモリの容量は80GBもあり、CUDAコア・Tensorコア数はそれぞれ14,592個・456個と、ハイスペックGPUの中でも特に優れたスペックを持っています。

そのため、「NVIDIA RTX A100」で7日間かかるような学習モデルでも、たった20時間で終えられるほど高速な処理が可能です。ただし、スペックが最高レベルである代わりに、販売価格の相場は約500万円とかなり高額です。スペックの特徴や相場から、H100は性能の高さを第一優先にしたい方におすすめのGPUです。

NVIDIA® RTX™ A100

NVIDIAのRTX A100は、AI開発向けのハイスペックGPUです。大規模な言語モデルでもスムーズに開発ができるように、80GBの大容量メモリと640個ものTensorコア・5,120個のCUDAコアが搭載されています。メモリ・Tensorコア共に、ハイスペックGPUの中でも特に搭載数が多く、他のGPUでは動かせないような大規模なディープラーニングモデルでも問題なく動かせるスペックの高さが魅力です。

リソースやスペックを踏まえると、複数チームでディープラーニング開発を行う場合に適したGPUといえます。

AMD Instinct™ MI210

MI210は、AI向けに提供されるAMD製のハイスペックGPUです。GPUメモリの容量は64GBで、コンピュータユニット(CU)とストリーミング・プロセッサー(SP)は、それぞれ104個と6,656個搭載されており、同シリーズの中でも高速な演算処理が可能となっています。そのため、MI210は同じAI開発向けハイスペックGPUの「NVIDIA A100」よりも、約2.3倍高いパフォーマンスを出せているケースも報告されています。

A100よりも高パフォーマンスを実現できる一方で、販売価格は約200万円とA100と比較して20万円程度安く購入できるメリットがあります。このような特徴から、MI210は性能もコストも妥協したくない方におすすめのGPUです。

NVIDIA® RTX™ A4500

A4500は、3DCAD・AI・シミュレーションなど、高度な処理でも使えるパワフルさが魅力のハイスペックGPUです。メモリ容量は20GBとハイスペックGPUの中では少ないものの、CUDAコアとTensorコアはそれぞれ7,168個と224個と十分な数を搭載し、処理性能の高さがうかがえます。

また、A4500は同Aシリーズの中ではミドルモデルとされているため、A5000やA6000は約30〜60万円程度で販売されているのに対して、A4500は約25万円前後とコストパフォーマンスに優れる点も魅力です。そのため、A4500はコスト面を重視する方に適しているGPUです。

NVIDIA® RTX™ A2000

A2000は、中規模レベルの機械学習・ディープラーニングモデル開発に適しているハイスペックなGPUです。メモリ容量は6GBでCUDAコアが3,328個、Tensorコアは104個です。メモリ容量が少ないため、大規模なディープラーニングの開発には向いていませんが、小・中規模レベルの機械学習モデル用のGPUとしては十分なメモリとコアを搭載しています。

また、A4500やA6000のサイズが「幅266.7ミリ×高さ111.15ミリ」であるのに対して、A2000は「幅169.55ミリ×高さ68.9ミリ」とひと回りほど小さく軽量です。

販売価格は10万円程度の手ごろな価格帯で提供されており、スペック・サイズ感・料金を踏まえると、機械学習を行う個人用のGPUとして適しています。

機械学習やディープラーニングにおすすめのGPU:ミドルパフォーマンス

上でご紹介したGPUは、いずれも極めて高価なモデルであることから、気軽な導入は難しいのがデメリットとなっています。ここで、GPUの中でも比較的価格帯が落ち着いている、ミドルクラスのモデルを紹介します。

GeForce RTX 3090 Ti

NVIDIAが提供するGeforceシリーズは、家庭用GPUとして最もポピュラーなモデルの一つです。中でも、RTX 3900 Tiは現世代機の中では安定したパフォーマンスを発揮できる、導入ハードルの低いモデルです。

主にゲーミングPCに導入することを前提としているモデルですが、最大で8K画質にも対応するほどのスペックを誇っており、演算処理能力の高さがうかがえます。機械学習においても十分な処理能力を発揮できることが期待でき、ビジネス向けGPUとして活躍します。

Radeon RX 6950 XT

Radeon RX 6950 XTは、RTX 3090と同等のスペックを有するAMD社のミドルクラスGPUです。同社独自の技術であるAMD Smart Access Memoryテクノロジーは、CPUと連携することでGPUのパフォーマンスをさらに高め、仕様以上の演算能力を発揮できるという強みを実現しています。

CPUも広く普及しているAMD社ならではの強みを、こちらのモデルで十分に体感できるでしょう。

GeForce RTX 4090

GeForce RTX 4090は、ディープラーニング開発向けに提供されるNVIDIA製のミドルレンジGPUです。メモリ容量とCUDAコアは、それぞれ24GBと16,384個もあるため、処理が重たくなるディープラーニングモデルでもスムーズに実行できます。

さらには、2023年時点で最新の「第4世代のTensorコア」が512基も搭載されており、Tensorコアのスペックと搭載数はH100に並ぶくらい高性能です。また、GeForce RTXシリーズはゲーミングPCとしても利用でき、GeForce RTX 4090は高度な光源計算技術にリアルな描画ができる「レイトレーシング」に加えて、美しいグラフィックスと高パフォーマンスを両立できる「ディープラーニングスーパーサンプリング(DLSS) 3.0」にも対応しています。

GeForce RTX 4090は、機械学習やディープラーニングをするためだけではなく、ゲーミングPCとしても活用できるマルチなGPUといえるでしょう。なお、DLSS 3.0については、『ディープラーニングスーパーサンプリングとは?有効にすべき?概要とメリット』で詳しく解説しています。

NVIDIA® T400

NVIDIAのT400は、機械学習向けのミドルレンジGPUです。メモリ容量は4GBでCUDAコアは384個と、ミドルレンジGPUの中でも特にコンパクトなモデルといえます。また、Tensorコアは搭載されていないため、ディープラーニングよりはニューラルネットワークやクラスタリングなどの小規模なモデルの開発環境として適しています。

スペックのコンパクトさゆえに、値段も手ごろで5万円程度で購入可能です。スペックや価格から、T400は機械学習のテスト環境やデータ作成時に使う個人用のGPUとしておすすめです。

Radeon VII

Radeon VIIは、ゲーミングPC向けに開発されたAMD製のGPUです。メモリ容量が16GBで、CU数・SP数がそれぞれ60個と3,840個と、高スペックな構成となっています。そのため、ゲーミングPC向けとはいえ、小・中規模の機械学習モデルであればスムーズに動かせるでしょう。

また、高性能にもかかわらず、10万円以下で購入できる点も嬉しいポイントです。このような特徴から、Radeon VIIはコストパフォーマンスを重視する場合におすすめのGPUです。

Radeon RX Vega 56

Radeon RX Vega 56は、機械学習・ディープラーニングなどで必要になるビックデータを処理するために開発されたAMD製のGPUです。メモリ容量が8GBで、CU数・SP数がそれぞれ56個と3,584個と、機械学習モデルを動かすうえで十分なスペックを持っています。

Vega 56は低価格でエントリーモデルとして販売されていることからも、機械学習用の個人向けGPUとして適しています。

機械学習やディープラーニングにGPU以外で必要なスペック

ディープラーニングにおいてGPUが必要なのはすでに紹介のとおりですが、それ以外のスペックについてはどのような点に注目すべきなのでしょうか?

CPU

GPU以外で注目すべきスペックとしては、まずCPUが挙げられます。CPUは直接ディープラーニングの処理を行うことはありませんが、PC本体の処理速度を高め、ソフトの起動などのパフォーマンスを改善してくれるため、ある程度こだわってみても良いでしょう。

2023年2月現在、最新のCPUはインテルの第12世代Coreで、できるだけ新しい世代のCPUを導入できればベターです。

メモリ

GPUのメモリはディープラーニングの処理速度に大きく貢献しますが、PC本体のメモリサイズは大きな影響を与えません。ただ、CPUと同様にPC本体の処理速度には大きく影響を与えるため、できるだけ大きいものが理想です。

メモリサイズは8GBが一般的な大きさですが、これより大きなモデルを用意できると、実感できるレベルで処理速度が変わってきます。

ストレージ

機械学習やディープラーニングでは、とにかく多くの学習データを用意する必要がありますが、その保管はクラウドストレージや外部の記憶媒体で行うことが一般的です。

ただ、PCに直接保存できるのであれば、読み込みの手間が省けるので、大きい方が、都合が良いのは間違いありません。近年は1TBや2TBのストレージを簡単に導入できるので、検討をおすすめします。

機械学習やディープラーニングにおけるGPU運用の注意点

人工知能開発にGPUは欠かせない存在ですが、一方で運用における注意点もあります。GPUを購入する前に、以下の点に気をつけておきましょう。

事前にデータベースを確保する

まず、機械学習を実施する上では、何よりも学習データを用意することが大事です。いわゆるビッグデータと言われる膨大なデータは、AIの発展に不可欠な一方、無料で気軽に得られるものでもありません。

ビッグデータを手に入れるためにはお金をかけなければならないケースも多く、まずはデータを確保するところから始めるべきでしょう。どれだけ優れたGPUがあっても、読み込ませるためのデータがなければ意味がありません。

多少GPUの予算を削ってでも、有益なデータベースを入手することが大切です。

PC用のGPUではスペック不足の可能性もある

本格的なGPU運用を進める場合、個人利用のPC向けGPUでは、その運用に限界もあります。PCに収まる程度のGPUではキャパシティが足りず、膨大な時間を必要としてしまうためです。

AI開発を効率良く進める上で重要なのが、GPUサーバーの活用です。独立したGPUの豊富なリソースを活用することで、スピーディーに開発が行えます。

上記で紹介したNVIDIAのTeslaシリーズなどは、このようなGPUサーバーを設置するために使われる製品です。しかし、自前でサーバーを導入するのには多額の費用がかかるため、気軽に導入することが難しいのがデメリットです。

クラウドGPUを導入するメリット

GPUのリソースを必要としているけれど、GPUサーバーを導入するほどの予算がない方におすすめなのが「クラウドGPU」です。ここでは、クラウドGPUを導入するメリットについて解説していきます。

導入が簡単である

クラウドGPUは、クラウド経由でGPUサーバーにアクセスし、必要な分だけリソースを確保できるサービスです。簡単な申し込み手続きをするだけですぐに利用を開始できるため、迅速な導入を支援してくれます。

GPUサーバーをオンプレミスで用意するのには日数もかかりますが、クラウドであればその点は問題ありません。

コストパフォーマンスが高い

クラウドGPUは初期費用が発生しないので、コストパフォーマンスに優れます。料金は使用したリソースに応じて決定されたり、月額の定額料金だったりするので、経済的な利用を促します。

オンプレミスとは異なり、GPUが必要なくなった時点で契約を解除もできるため、柔軟な使い方ができます。

パワフルに運用できる

クラウド経由とはいえ、実際の使い心地はGPUサーバーのそれと遜色ありません。豊富なリソースを必要なだけ利用できるので、スケーラブルにプロジェクトを進められます。

BCP対策を実現できる

自社でサーバーを管理する必要がなくなるため、BCP対策にも役立ちます。自社が災害などで機能しなくなっても、サーバー本体は別の地域に設置されておりバックアップ体制も整っているので、会社機能を失わずに済みます。

インターネット経由でサーバーを利用できるため、テレワークの実施にも活躍するサービスです。

機械学習・ディープラーニング向けクラウドGPUはM:CPPがおすすめ

クラウドGPUの利便性の高さは多くの企業が認めており、導入が進みつつあります。クラウドGPUには多様なサービスが揃っていますが、機械学習やディープラーニングでの運用を検討している場合、おすすめしたいのが、当社モルゲンロットが提供する「M:CPP」です。

M:CPPとは

M:CPPは、導入企業のエンジニアが本来の開発業務へ集中できるよう、包括的なサポートを提供するクラウドGPUです。ただクラウド経由でGPUリソースを提供するだけでなく、GPU運用に伴う課題の解決に貢献することを強みとしており、他のサービスにはない独自のアドバンテージを有しています。

個人から法人まで、利用者に制限はなく、GPUリソースを必要としている方であれば誰でも相談していただくことができます。新しいGPUクラウドを契約する際、負担となるのがサービスの選定です。

M:CPPのご利用に当たっては、当社のエンジニアがおすすめのプランを提案するため、時間をかけて検討する必要はありません。自社の課題を洗い出し、その上サービスごとの違いやスペックを検討しなければならないのは負担の大きい業務ですが、M:CPPではその負担を解消することができます。

おすすめの理由

M:CPPをおすすめできる理由は、ただ導入がしやすいからというだけにとどまりません。他のクラウドGPUにはない強みを持っており、導入企業の課題解決に貢献します。

大手クラウドよりもコストパフォーマンスに優れる

他のクラウドサービスと比べ、M:CPPはその料金設定が安価に設定されています。契約プランにもよりますが、場合によっては大手クラウドGPUよりも1/2以下という費用で利用できるものもあり、費用対効果を高めたい方には最適のサービスでしょう。

クラウドGPU導入は、契約内容によってはコストパフォーマンスの改善が思ったほど得られないというケースもあります。M:CPPであれば、初めてのクラウド利用の方はもちろん、コスト面の都合で他のクラウドGPUからの乗り換えを検討している方にも、自信を持っておすすめできます。

専有サーバーで高い演算能力を発揮できる

M:CPPのクラウドGPUは、ただ安価であるだけでなく、その品質にも強みを有しています。導入しているのは最新のAMD製GPUであり、スペックは他のサービスに劣りません。

また、利用の際にはユーザーごとに専有サーバーが提供されるため、他のユーザーの干渉を受けることもないことが強みです。

複数ユーザーでサーバーをシェアする場合、お互いの使用が相互に干渉し合う「ノイジーネイバー」現象が起きることもあります。しかし、M:CPPではその問題を心配する必要はないでしょう。

多数のフレームワークに対応している

機械学習やディープラーニングでの運用を検討している方は、M:CPPが対応する豊富なフレームワークの恩恵を受けることができます。

AI開発の効率を飛躍的に高めてくれる各種ライブラリやフレームワークは、場合によってはクラウドGPU上で動作しないこともあります。M:CPPでは、ROCm環境を採用しており、基本的にはROCmに対応しているフレームワークであれば、問題なく運用することができます。

一部のフレームワークについてはM:CPPで検証を終えていないものもありますが、PyTorchやTensorFlowなど、ポピュラーなサービスは確実に使用可能です。

まとめ

近年、機械学習やディープラーニング事業のニーズ増加に伴い、インターネット経由で簡単に導入できる「クラウドGPUサービス」が増えてきています。さまざまな機械学習・ディープラーニング開発向けのクラウドGPUサービスがある中でもっともおすすめなのが、当社モルゲンロットの「M:CPP」です。

M:CPPとは、「Radeon VIIやRadeon RX Vega 56」などの高性能なAMD製GPUを格安で提供しているクラウドGPUサービスです。また、TensorflowやPytorchなどの実行環境や、OSなどのシステム環境を構築する手間なく、契約してすぐに機械学習・ディープラーニングの開発を開始いただくことも可能です。

そのため、GPU導入にかかるコストや環境構築がネックとなり、機械学習・ディープラーニング事業への参入を諦めていた企業の皆さまも、まずは当社のM:CPPを利用してみてはいかがでしょうか?